Resumen

En los casos que no previstos en este Protocolo u otros acuerdos internacionales, civiles y combatientes permanecen bajo la protección y la autoridad del derecho internacional, derivado de la costumbre establecida, de los principios de la humanidad y de los dictados de conciencia pública.

— Cláusula Martens, como se indica en el Protocolo Adicional 1977 de los Convenios de Ginebra

Las armas completamente autónomas son algunas de las tecnologías militares en desarrollo más alarmantes en la actualidad. Por esta razón, hay una necesidad urgente para que los Estados, expertos y el púbico en general, examinen estas armas bajo la Cláusula Martens, la única provisión de derecho internacional humanitario que establece una línea base para la protección de los civiles y los combatientes, dado que no existe ningún tratado específico sobre este tema. Este reporte muestra cómo las armas completamente autónomas, que tienen la capacidad de seleccionar y atacar blancos sin control humano, infringen la Cláusula Martens, los principios de la humanidad y los dictados de conciencia pública. Para cumplir con la Cláusula Martens, los Estados deberían adoptar una prohibición preventiva del desarrollo, producción y uso de las armas.

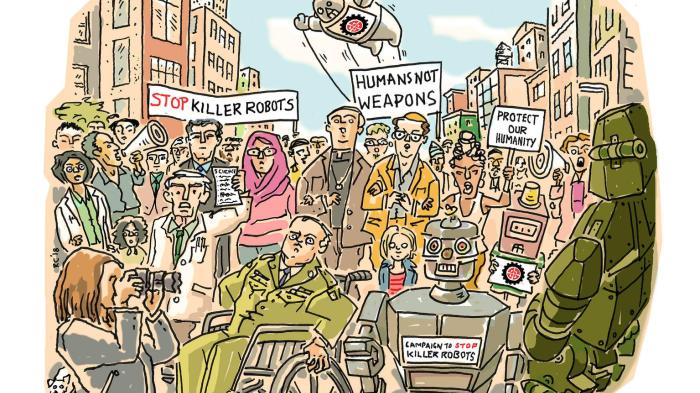

El rápido desarrollo de la tecnología autónoma y la inteligencia artificial (IA) implica que las armas completamente autónomas, podrían convertirse en una realidad en el futuro. Además, los llamados “robots asesinos” y los sistemas letales de armas completamente autónomas levantan una gran cantidad de preocupaciones morales, legales, de responsabilidad, operacionales, técnicas y de seguridad. Estas armas han sido sujeto de debate internacional desde 2013. En ese año, fue lanzada una coalición de sociedad civil, la Campaña contra los Robots Asesinos, y empezó a presionar a los Estados para discutir sobre las armas. Luego de que se realizarán tres reuniones informales de expertos, los Estados parte la Convención sobre Ciertas Armas Convencionales (CCAC), iniciaron charlas formales sobre el tema en 2017. En agosto de 2018, aproximadamente 80 Estados serán convocados nuevamente para la próxima reunión del Grupo de Expertos Gubernamentales de la CCAC.

A medida que los Estados parte de la CCAC evalúan las armas completamente autónomas y el camino a seguir, la Cláusula Martens debería ser un elemento central en las discusiones. La cláusula, que es una característica común del derecho internacional humanitario y de los tratados de desarme, declara que en ausencia de un acuerdo internacional, la costumbre establecida, los principios de la humanidad y los dictados de conciencia pública deberían proveer protección para civiles y combatientes. La cláusula aplica a las armas completamente autónomas porque no son abordadas específicamente por el derecho internacional. Los expertos difieren sobre la significancia legal precisa de la Cláusula Martens, específicamente, sobre si refiere al derecho consuetudinario, equivale a una fuente independiente del derecho o sirve como una herramienta de interpretación. Mínimamente, sin embargo, la Cláusula Martens provee factores claves para que los Estados consideren mientras evalúan una tecnología de armas emergente, incluyendo armas completamente autónomas. Crea una norma moral para juzgar dichas armas.

Los Principios de la Humanidad

Debido a su falta de emoción y juicio legal y ético, las armas completamente autónomas se enfrentarían a obstáculos significativos para cumplir con los principios de la humanidad. Esos principios requieren el trato humano de los demás, el respeto por la vida humana y la dignidad humana. Los seres humanos están motivados a tratarse entre sí humanamente, porque sienten compasión y empatía por sus semejantes. El juicio legal y ético proporciona a las personas los medios para minimizar el daño; les permite tomar decisiones consideradas basadas en la comprensión de un contexto particular. Como máquinas, las armas completamente autónomas no serían seres sensibles capaces de sentir compasión. En lugar de ejercer un juicio, tales sistemas de armas basarían sus acciones en algoritmos preprogramados, que no funcionan bien en situaciones complejas e impredecibles.

Mostrar respeto por la vida humana implica minimizar la matanza. El juicio ético y legal ayuda a los seres humanos a sopesar diferentes factores, para evitar la pérdida arbitraria e injustificada de vidas en conflictos armados. Sería difícil recrear ese juicio, desarrollado tanto en la historia de la humanidad como en la vida individual, en armas completamente autónomas, y no se podrían preprogramar para enfrentar todos los escenarios posibles de acuerdo con las normas legales y éticas aceptadas. Además, la mayoría de los humanos poseen una resistencia innata a la matanza, que se basa en su comprensión del impacto de la pérdida de vidas, que las armas completamente autónomas, como máquinas inanimadas, no podrían compartir.

Incluso si las armas completamente autónomas pudieran proteger adecuadamente la vida humana, serían incapaces de respetar la dignidad humana. A diferencia de los seres humanos, estos robots serían incapaces de apreciar plenamente el valor de una vida y el significado de su pérdida. Tomarían decisiones de vida o muerte basadas en algoritmos, reduciendo sus objetivos humanos a objetos. Las armas completamente autónomas violarían así los principios de la humanidad en todos los frentes.

Los dictados de la conciencia pública

El aumento de la indignación ante un panorama de armas completamente autónomas, sugiere que esta nueva tecnología también va en contra de la segunda parte de la Cláusula Martens, los dictados de la conciencia pública. Estos dictados consisten en pautas morales basadas en el conocimiento de lo que es correcto e incorrecto. Pueden determinarse a través de las opiniones del público y de los gobiernos.

Muchos individuos, expertos y gobiernos se han opuesto enérgicamente al desarrollo de armas completamente autónomas. Múltiples encuestas de opinión pública han registrado oposición a estas armas. Los expertos, que han examinado el tema con mayor profundidad, han emitido cartas abiertas y declaraciones que reflejan conciencia, incluso mejor que las encuestas. Las organizaciones internacionales y las organizaciones no gubernamentales (ONG), junto con los líderes en materia de desarme y derechos humanos, paz y religión, ciencia y tecnología, y la industria, se han visto obligados, en particular por razones morales, a pedir la prohibición de armas completamente autónomas. Han condenado estas armas como "inconcebibles", "aborrecibles (...) a lo sagrado de la vida", "imprudentes" y "poco éticas".

Los gobiernos han incluido el cumplimiento de la Cláusula Martens y las deficiencias morales, entre sus principales preocupaciones en relación a las armas completamente autónomas. A partir de julio de 2018, 26 estados apoyaron una prohibición preventiva y más de 100 Estados habían pedido un instrumento legalmente vinculante para abordar las preocupaciones planteadas por los sistemas de armas autónomos letales. Casi todos los partidos estatales de la CCAC que hablaron en su última reunión en abril de 2018, destacaron la necesidad de mantener el control humano sobre el uso de la fuerza. El consenso emergente para preservar un control humano significativo, que es efectivamente equivalente a una prohibición de armas que carecen de tal control, muestra que la conciencia pública está fuertemente en contra de las armas completamente autónomas.

La necesidad de un Tratado de Prohibición Preventiva

Una evaluación de las armas completamente autónomas bajo la Cláusula Martens subraya la necesidad de una nueva ley, que sea específica y fuerte. Las regulaciones que permitieran la existencia de armas completamente autónomas no serían suficientes. Por ejemplo, limitar el uso a ciertos lugares no evitaría el riesgo de proliferación para los actores con poco respeto por el trato o la vida humana, ni garantizaría el respeto por la dignidad de los civiles o combatientes. Además, la conciencia pública revela un amplio apoyo a la prohibición de las armas completamente autónomas, o su equivalente, un requisito para el control humano significativo. Para garantizar el cumplimiento de los principios de la humanidad y los dictados de la conciencia pública, los Estados deben, por lo tanto, prohibir de manera preventiva el desarrollo, la producción y el uso de armas completamente autónomas.

Recomendaciones

Para evitar los riesgos legales, morales y de otra índole que plantean las armas completamente autónomas y la pérdida del control humano significativo sobre la selección y el compromiso de los objetivos, Human Rights Watch y la Clínica Internacional de Derechos Humanos de la Escuela de Derecho de Harvard (IHRC) recomiendan:

A los Estados parte de la CCAC

- Adoptar, en su reunión anual en noviembre de 2018, un mandato para negociar un nuevo protocolo que prohíba los sistemas de armas autónomos, o sistemas de armas letales autónomas, con miras a concluir las negociaciones para fines de 2019.

- Utilizar la reunión del Grupo de Expertos Gubernamentales de agosto de 2018 para presentar posiciones nacionales claras y llegar a un acuerdo sobre la necesidad de adoptar un mandato de negociación, en la reunión anual de noviembre.

- Desarrollar posiciones nacionales y adoptar prohibiciones nacionales, como pilares clave para lograr la prohibición internacional.

- Expresar su oposición a las armas completamente autónomas, incluso en los términos legales y morales reflejados en la Cláusula Martens, para desarrollar aún más la conciencia pública existente.

A expertos en el sector privado

- Oponerse a la eliminación del control humano significativo de los sistemas de armas y al uso de la fuerza.

- Expresar públicamente su apoyo explícito al llamado a prohibir las armas completamente autónomas, incluso en los términos morales y legales reflejados en la Cláusula Martens, e instar a los gobiernos a comenzar a negociar nuevas leyes internacionales.

- Comprometerse a no diseñar o desarrollar IA para su uso en la creación de armas completamente autónomas, a través de códigos de conducta, declaraciones de principios y otras medidas que aseguren que el sector privado no avance en el desarrollo, producción o uso de armas completamente autónomas.

I. Antecedentes de las armas completamente autónomas

Las armas completamente autónomas serían capaces de seleccionar y atacar objetivos sin un control humano significativo. Representan un paso inaceptable, más allá de los drones armados existentes, porque un humano no tomaría la decisión final sobre el uso de la fuerza en ataques individuales. Las armas completamente autónomas, también conocidas como sistemas letales de armas autónomas y "robots asesinos" aún no existen, pero están en desarrollo y las inversiones militares en tecnología autónoma están aumentando a un ritmo alarmante.

Los riesgos de las armas completamente autónomas superan sus supuestos beneficios. Los defensores destacan que la nueva tecnología podría salvar la vida de los soldados, procesar datos y operar a velocidades más altas que los sistemas tradicionales, además de ser inmunes al miedo y la ira, evitando así víctimas civiles. Sin embargo, plantean una gran cantidad de preocupaciones, muchas de las cuales Human Rights Watch ha destacado en publicaciones anteriores. Primero, delegar las decisiones de vida o muerte a las máquinas cruza una línea roja moral. En segundo lugar, las armas completamente autónomas se enfrentarían a desafíos importantes que incumplen con el derecho internacional humanitario. En tercer lugar, crearían un vacío de responsabilidad porque sería difícil responsabilizar a una persona por los daños imprevistos causados por un robot autónomo. Cuarto, las armas completamente autónomas serían vulnerables a la falsificación y a la piratería. En quinto lugar, estas armas podrían amenazar la seguridad mundial porque podrían conducir a una carrera de armamentos, proliferar en actores con poco respeto por el derecho internacional y bajar el umbral a la guerra.[1]

Este informe se enfoca en otra preocupación, que abarca la ley y la moralidad, es decir, la probabilidad de que armas completamente autónomas contravengan la Cláusula Martens. Esta disposición del derecho internacional humanitario requiere que los Estados tomen en cuenta los principios de la humanidad y los dictados de la conciencia pública, al examinar la tecnología de las armas emergentes. Una característica común en los convenios de Ginebra y los tratados de desarme, la cláusula representa una obligación legal de los Estados de considerar cuestiones morales.

La gran cantidad de problemas que presentan las armas completamente autónomas, incluidas los de la Cláusula Martens, exigen medidas urgentes. Algunos Estados han propuesto un enfoque de esperar y ver, dado que no está claro qué tecnología podría ser desarrollada. Sin embargo, las apuestas involucradas apuntan a la necesidad de un enfoque de precaución. La incertidumbre científica no debe interponerse en el camino de la acción para prevenir lo que algunos científicos han denominado “la tercera revolución en la guerra, después de la pólvora y las armas nucleares”.[2] Los países deberían adoptar una prohibición preventiva sobre el desarrollo, la producción y el uso de sistemas completamente autónomos.

II. Historia de la Cláusula Martens

Si bien la cláusula de Martens se originó en un compromiso diplomático, ha servido para fines humanitarios. Afirma que, en ausencia de una ley de tratados específicos, las costumbres establecidas, los principios de la humanidad y los dictados de la conciencia pública brindan protección a los civiles y combatientes. Desde su introducción, la Cláusula Martens se ha convertido en una característica común de los instrumentos fundamentales del derecho internacional humanitario. La cláusula también aparece en numerosos tratados de desarme. Las protecciones que proporciona la Cláusula Martens y el reconocimiento legal que ha recibido destacan su valor para examinar los sistemas de armas emergentes que podrían causar daños humanitarios en el campo de batalla y más allá.

Orígenes de la Cláusula Martens

La Cláusula Martens apareció por primera vez en el preámbulo del Convención de La Haya de 1899, que contiene el Reglamento sobre las leyes y las costumbres de la guerra terrestre. En esa iteración, la cláusula de Martens establece:

Hasta que se emita un código más completo de las leyes de la guerra, las Altas Partes Contratantes consideran correcto declarar que, en los casos que no están incluidos en el Reglamento adoptado por ellas, las poblaciones y los beligerantes permanecen bajo la protección y el imperio de los principios del derecho internacional, como resultan de los usos establecidos entre las naciones civilizadas, de las leyes de la humanidad y de los requisitos de la conciencia pública.[3]

Por lo tanto, la cláusula proporciona un nivel básico de protección para civiles y combatientes cuando no existe una ley específica.

El diplomático y jurista ruso, Fyodor Fyodorovich Martens, propuso la Cláusula Martens como una forma de romper el estancamiento de las negociaciones en la Conferencia de la Paz de La Haya de 1899, que se había convocado para adoptar reglas que restringieran la guerra, redujeran el gasto en armas y promovieran la paz.[4] Las grandes potencias y las potencias menores no estaban de acuerdo sobre la cantidad de autoridad que podían ejercer las fuerzas de ocupación sobre la población local. Las grandes potencias insistieron en la creación de un nuevo tratado que aclarara los derechos y obligaciones de las fuerzas de ocupación, mientras que las potencias menores se opusieron a la codificación de las disposiciones de una declaración política anterior, que creían que no protegía adecuadamente a los civiles. La Cláusula Martens otorgó a los combatientes, frente a la ocupación extranjera, la opción de argumentar que si las disposiciones específicas del tratado no los defendían, tenían derecho al menos, a la protección que ofrecen los principios del derecho internacional derivados de la costumbre, “las leyes de la humanidad” y “los requisitos de la conciencia pública”.[5]

Uso moderno de la Cláusula Martens

En los casi 120 años transcurridos desde la adopción del Convenio de La Haya de 1899, la Cláusula Martens se ha aplicado de manera más amplia y se ha convertido en un elemento básico de los esfuerzos para extender la protección humanitaria durante los conflictos armados. Buscando reducir el impacto de las hostilidades, numerosos instrumentos del derecho internacional humanitario y el derecho de desarme han incorporado la disposición.

Convenios de Ginebra y Protocolo Adicional I

Al redactar los Convenios de Ginebra de 1949, los pilares del derecho internacional humanitario,[6] los negociadores querían garantizar que ciertas protecciones continuaran, en caso de que un Estado parte decidiera retirarse de cualquiera de los tratados. Los cuatro Convenios de Ginebra contienen la Cláusula Martens en sus artículos sobre denuncias, que abordan las implicancias de que un Estado deje los tratados.[7] En su comentario autoritario sobre las convenciones, el Comité Internacional de la Cruz Roja (CICR), el árbitro del derecho internacional humanitario, explica:

Si una Alta Parte Contratante tuviera que denunciar uno de los Convenios de Ginebra, continuaría estando obligada no solo por otros tratados de los que sigue siendo Parte, sino también por otras normas de derecho internacional, como el derecho consuetudinario. Por lo tanto, un acuerdo en contrario, que sugiere un vacío legal luego de la denuncia de un convenio, es imposible.[8]

El Protocolo adicional I, que fue adoptado en 1977, amplía las protecciones otorgadas a los civiles por el Cuarto Convenio de Ginebra.[9] El protocolo contiene la versión moderna de la Cláusula Martens y la versión utilizada en este informe:

En los casos no cubiertos por este Protocolo o por otros acuerdos internacionales, los civiles y los combatientes permanecen bajo la protección y autoridad de los principios del derecho internacional derivados de las costumbres establecidas, los principios de la humanidad y los dictados de la conciencia pública.[10]

Al incorporar este lenguaje en su artículo sobre “Principios generales y ámbito de aplicación” en lugar de limitarlo a una disposición sobre denuncia, el Protocolo adicional I extiende la aplicación de la Cláusula Martens. Según el comentario del CICR:

Hubo dos razones por las que se consideró útil incluir esta cláusula nuevamente en el Protocolo. Primero (...) no es posible que ninguna codificación esté completa en un momento dado; por lo tanto, la Cláusula Martens previene la suposición de que cualquier cosa que no esté explícitamente prohibida por los tratados relevantes esté, por lo tanto, permitida. En segundo lugar, debe verse como un factor dinámico que proclama la aplicabilidad de los principios mencionados, independientemente de los desarrollos posteriores de tipos de situación o tecnología.[11]

La Cláusula Martens, por lo tanto, cubre los vacíos existentes en la legislación y promueve la protección de los civiles frente a nuevas situaciones o tecnologías.

Tratados de desarme

Desde 1925, la mayoría de los tratados que contienen prohibiciones de armas también incluyen la Cláusula Martens.[12] Se refiere a la cláusula de varias formas en los preámbulos del Protocolo de Gas de Ginebra de 1925,[13] la Convención sobre las Armas Biológicas de 1972,[14] Convención sobre Armas Convencionales de 1980,[15] Convención sobre la prohibición de minas antipersonales de 1997,[16] Convención sobre Municiones en Racimo de 2008[17] y el Tratado sobre la Prohibición de las Armas Nucleares de 2017.[18] Aunque un preámbulo no establece reglas vinculantes, puede informar la interpretación de un tratado y se suele utilizar para incorporar, por referencia, el contexto de la ley ya existente. La inclusión de la Cláusula Martens indica que si las disposiciones operativas de un tratado presentan vacíos, deben llenarse con las costumbres establecidas, los principios de humanidad y los dictados de la conciencia pública. Al incorporar la Cláusula Martens en esta línea de tratados de desarme, los Estados han reafirmado su importancia para el derecho internacional humanitario en general y para el derecho de armas en particular.

El uso generalizado de la Cláusula Martens la hace relevante para las discusiones actuales sobre armas completamente autónomas. La cláusula proporciona una norma para garantizar que los civiles y los combatientes reciban al menos las protecciones mínimas de tales armas problemáticas. Además, la mayoría de las discusiones diplomáticas sobre armas completamente autónomas han tenido lugar bajo los auspicios de la CCAC, que incluye la Cláusula Martens en su preámbulo. Por lo tanto, una evaluación de armas completamente autónomas bajo la Cláusula Martens debería jugar un papel clave en las deliberaciones sobre un nuevo protocolo de la CCAC.

III. Aplicabilidad y significado de la Cláusula Martens

La Cláusula Martens se aplica en ausencia de una ley específica sobre un tema. Los expertos no están de acuerdo con su importancia legal, pero como mínimo, proporcionan factores que los Estados deben tener en cuenta al examinar los nuevos desafíos planteados por las tecnologías emergentes. Su importancia para el derecho de desarme en particular es evidente en las negociaciones que llevaron a la adopción de una prohibición preventiva de los láseres cegadores. Por lo tanto, los Estados y otros deben tener en cuenta la cláusula al analizar la legalidad de las armas completamente autónomas y la mejor manera de abordarlas.

Aplicabilidad de la Cláusula Martens

La Cláusula Martens, según lo establecido en el Protocolo adicional I, aplica “en casos no cubiertos” por el protocolo o por otros acuerdos internacionales.[19] No importa cuán cuidadosos sean, los redactores de tratados no pueden prever y abarcar todas las circunstancias en un solo instrumento. La cláusula de Martens sirve como una medida provisional para garantizar que una situación no anticipada o una tecnología emergente no subviertan el propósito general del derecho humanitario simplemente porque ninguna disposición de un tratado existente lo cubre explícitamente.[20]

La Cláusula Martens se activa cuando el derecho de los tratados existentes no aborda específicamente una determinada circunstancia. Como lo explicó el Tribunal Militar de los Estados Unidos en Nüremberg, la cláusula hace que “los usos establecidos entre las naciones civilizadas, las leyes de la humanidad y los dictámenes de la conciencia pública en el criterio legal, se apliquen cuando las disposiciones específicas de [la ley existente] no cubran casos específicos que ocurren en la guerra”.[21] Es particularmente relevante para las nuevas tecnologías que los redactores de leyes existentes pueden no haber predicho. Al enfatizar que la cláusula de "la continua existencia y aplicabilidad no debe ponerse en duda", la Corte Internacional de Justicia destacó que “ha demostrado ser un medio eficaz para abordar la rápida evolución de la tecnología militar”.[22] Dado que a menudo hay una escasez de ley en esta área, la Cláusula Martens proporciona un estándar para armas emergentes.

Como una forma de tecnología en rápido desarrollo, las armas completamente autónomas ejemplifican un tema apropiado para la Cláusula Martens. El derecho internacional humanitario existente se aplica a las armas completamente autónomas solo en términos generales. Requiere que todas las armas cumplan con los principios básicos de distinción y proporcionalidad, pero no contiene reglas específicas para tratar con armas completamente autónomas.[23] Los redactores de los Convenios de Ginebra no podrían haber imaginado la posibilidad de un robot que pudiera hacer determinaciones independientes sobre cuándo usar la fuerza sin un control humano significativo. Dado que las armas completamente autónomas presentan un caso no cubierto por la ley existente, deben ser evaluadas bajo los principios articulados en la Cláusula Martens.

Significancia legal de la Cláusula Martens

Las interpretaciones del significado legal de la Cláusula Martens varían.[24] Algunos expertos adoptan una perspectiva estrecha, afirmando que la Cláusula Martens sirve simplemente como un recordatorio de que si un tratado no prohíbe expresamente una acción específica, la acción no se permite automáticamente. En otras palabras, los Estados deben referirse al derecho internacional consuetudinario cuando el derecho de los tratados guarda silencio sobre un tema específico.[25] Sin embargo, este punto de vista es discutiblemente insatisfactorio porque aborda solo un aspecto de la cláusula, la costumbre establecida, y no tiene en cuenta el papel de los principios de la humanidad y los dictados de la conciencia pública. Bajo reglas de interpretación legal bien aceptadas, se debe leer una cláusula para dar sentido a cada uno de sus términos.[26] Tratar los principios de la humanidad y los dictados de la conciencia pública como simples elementos de una costumbre establecida los haría redundantes y violaría esta regla.

Otros argumentan que la Cláusula Martens es en sí misma, una fuente única de ley.[27] Sostienen que el lenguaje sencillo de la Cláusula Martens eleva los principios de la humanidad y los dictados de la conciencia pública a estándares legales independientes contra los cuales juzgar situaciones no anticipadas y formas emergentes de tecnología militar.[28] Sobre esta base, una situación o arma que entre en conflicto con cualquiera de las normas es per se ilegal.

El jurista de derecho internacional público Antonio Cassese adoptó un enfoque intermedio, al tratar los principios de la humanidad y los dictados de la conciencia pública como una “guía fundamental” para la interpretación del derecho internacional.[29] Cassese escribió que “en caso de duda, las reglas internacionales, en particular las reglas que pertenecen al derecho humanitario, deben interpretarse de modo que estén en consonancia con las normas generales de la humanidad y las demandas de la conciencia pública”.[30] Por lo tanto, debe entenderse que el derecho internacional no aprueba situaciones o tecnologías que suscitan inquietudes en relación con estos aspectos de la Cláusula Martens. Como mínimo, la Cláusula Martens proporciona factores que los Estados deben tener en cuenta a medida que se acercan a la tecnología de armas emergentes, incluidas las armas completamente autónomas. En 2018, el CICR reconoció el “debate sobre si la Cláusula Martens constituye un criterio legalmente vinculante contra el cual debe medirse la legalidad de un arma o más bien una directriz ética”.[31] Sin embargo, concluyó que “está claro que la humanidad y la conciencia pública han impulsado la evolución del derecho internacional sobre las armas y estas nociones han provocado la negociación de tratados específicos para prohibir o limitar ciertas armas”.[32] Si surgen inquietudes sobre un arma bajo los principios de humanidad o dictados de conciencia pública, la adopción de una ley nueva y más específica que elimine las dudas sobre la legalidad de un arma puede aumentar la protección de civiles y combatientes.

La Cláusula Martens también hace que las consideraciones morales sean legalmente relevantes. Está codificado en tratados internacionales, pero requiere evaluar una situación o tecnología de acuerdo con los principios de humanidad y los dictados de la conciencia pública, los cuales incorporan elementos de moralidad. Peter Asaro, un filósofo de la ciencia y la tecnología, escribe que la Cláusula Martens invita a la “reflexión moral sobre el papel de los principios de la humanidad y los dictados de la conciencia pública al articular y establecer un nuevo [derecho internacional humanitario]”.[33] Si bien una evaluación moral de armas completamente autónomas es importante por sí misma, la Cláusula Martens también hace que sea un requisito legal en ausencia de una ley específica.

Precedente de la prohibición preventiva de los láseres cegadores

Los Estados, las organizaciones internacionales y la sociedad civil han invocado la Cláusula Martens en deliberaciones previas sobre tecnología emergente no regulada.[34] Lo encontraron especialmente aplicable a las discusiones sobre los láseres cegadores en la década de 1990. Estos grupos se referían explícita e implícitamente a los elementos de la Cláusula Martens como justificación para prohibir de forma preventiva los láseres cegadores. El Protocolo IV de CCAC, adoptado en 1995, codifica la prohibición.[35]

Durante una mesa redonda convocada por el CICR en 1991, los expertos destacaron la relevancia de la Cláusula Martens. La abogada del CICR, Louise Doswald-Beck, argumentó que “las decisiones para imponer restricciones específicas sobre el uso de ciertas armas pueden basarse en consideraciones políticas” y que “los criterios consagrados en la Cláusula Martens [deberían] ser particularmente tomados en cuenta”.[36] Otro participante dijo que: “la Cláusula Martens aborda particularmente el problema del sufrimiento humano para que ‘la conciencia pública’ se refiera a lo que se considera inhumano o socialmente inaceptable”.[37]

Los críticos de los láseres cegadores hablaron en términos que demostraron que las armas plantean preocupaciones bajo los principios de la humanidad y los dictados de la conciencia pública. Varios oradores en las reuniones convocadas por el CICR coincidieron en que “las armas diseñadas para cegar son (...) socialmente inaceptables”.[38] El propio CICR apeló “a la conciencia de la humanidad” al abogar por una prohibición.[39] En la Primera Conferencia de Revisión de la CCAC, representantes de la agencias de la ONU y la sociedad civil describieron los láseres cegadores como "inhumanos”,[40] “aborrecibles a la conciencia de la humanidad”[41] e “inaceptable en el mundo moderno”.[42] Una campaña de concientización pública particularmente efectiva del CICR, utilizó fotografías de soldados cegados por gas venenoso durante la Primera Guerra Mundial para enfatizar el hecho de que el cegamiento permanente de los soldados es cruel e inhumano.

Tales caracterizaciones de los láseres cegadores estaban vinculadas a la necesidad de una prohibición preventiva. Por ejemplo, durante el debate en la Primera Conferencia de Revisión, Chile expresó su esperanza de que el organismo “podría establecer pautas de acción preventiva para prohibir el desarrollo de tecnologías inhumanas y, por lo tanto, evitar la necesidad de remediar la miseria que podrían causar”.[43] En una resolución de diciembre de 1995 que instaba a los Estados a ratificar el Protocolo IV, el Parlamento Europeo declaró que “el cegamiento deliberado como método de guerra es abominable”.[44] Utilizando el lenguaje de la Cláusula Martens, el Parlamento Europeo declaró que “el cegamiento deliberado como método de guerra está (...) en contravención de las costumbres establecidas, los principios de la humanidad y los dictados de la conciencia pública”.[45] El CICR dio la bienvenida al Protocolo IV como una “victoria de la civilización sobre la barbarie”.[46]

Las discusiones en torno al Protocolo IV de la CCAC subrayan la relevancia de la Cláusula Martens para el debate actual sobre armas completamente autónomas. Muestran que Estados parte de la CCAC tienen un historial de aplicación de la Cláusula Martens a las armas controvertidas. También demuestran la disposición de estos Estados para prohibir preventivamente un arma que encuentra contraria a los principios de la humanidad y los dictados de la conciencia pública. Como se analizará con mayor profundidad más adelante, las armas completamente autónomas plantean preocupaciones importantes en virtud de la Cláusula Martens. El hecho de que su impacto en el conflicto armado sea exponencialmente mayor que el de los láseres cegadores solo debería aumentar la urgencia de llenar el vacío en el derecho internacional y prohibirlos explícitamente.[47]

IV. Los principios de la humanidad

La Cláusula Martens divide los principios del derecho internacional en costumbres establecidas, los principios de la humanidad y los dictados de la conciencia pública. Dado que el derecho consuetudinario es aplicable incluso sin la cláusula, este informe evalúa las armas completamente autónomas bajo los últimos dos elementos. La Cláusula Martens no define estos términos, pero han sido objeto de mucha discusión académica y legal.

La literatura relevante ilumina dos componentes clave de los principios de la humanidad. Los actores deben: (1) tratar a los demás con humanidad y (2) mostrar respeto por la vida y la dignidad humanas. Debido a su falta de emoción y juicio, las armas completamente autónomas se enfrentarían a dificultades significativas para cumplir con cualquiera de ellas.

Trato humano

Definición

El primer principio de la humanidad requiere el trato humano de los demás. El Diccionario de Oxford define “humanidad” como “la calidad de ser humano; benevolencia”.[48] La obligación de tratar a los demás con humanidad es un componente clave del derecho internacional humanitario y de las normas internacionales de derechos humanos.[49] Aparece, por ejemplo, en el artículo 3 común y otras disposiciones de los Convenios de Ginebra, en numerosos manuales militares, en la jurisprudencia internacional y en el Pacto Internacional de Derechos Civiles y Políticos.[50] Más allá de estas fuentes, la Cláusula Martens establece que los seres humanos deben ser tratados humanamente, incluso cuando no existe una ley específica.[51]

Para tratar a otros seres humanos con humanidad, uno debe ejercer compasión y hacer juicios éticos y legales.[52] La compasión, según los principios fundamentales del CICR, es la “agitación del alma que hace que uno responda a la angustia de los demás”.[53] Para mostrar compasión, un actor debe poder experimentar empatía, es decir, comprender y compartir los sentimientos de otro y ser obligado a actuar en respuesta.[54] Esta capacidad emocional es vital en situaciones en las que se hacen determinaciones sobre el uso de la fuerza.[55] Impulsa a los actores a hacer esfuerzos conscientes para minimizar el daño físico o psicológico que infligen a los seres humanos. Actuar con compasión se basa en la premisa de que “la captura es preferible a herir a un enemigo y herirlo es mejor que matarlo; que los no combatientes se salvarán en la medida de lo posible; que las heridas infligidas sean lo más livianas posible, para que los heridos puedan ser tratados y curados; y que las heridas causan el menor dolor posible”.[56]

Mientras que la compasión proporciona una motivación para actuar humanamente, el juicio ético y legal proporciona un medio para hacerlo. Para actuar humanamente, un actor debe tomar decisiones consideradas sobre cómo minimizar el daño.[57] Tales decisiones se basan en la capacidad de percibir y comprender el entorno de uno y de aplicar el “sentido común y el conocimiento del mundo” a una circunstancia específica.[58] El profesor de filosofía James Moor señala que los actores deben poseer la capacidad de “identificar y procesar información ética sobre una variedad de situaciones y hacer determinaciones sensibles sobre lo que se debe hacer en esas situaciones”.[59] De esta manera, el juicio ético y legal ayuda a un actor a sopesar los factores relevantes para garantizar que el tratamiento cumpla con los estándares exigidos por la compasión. El juicio es vital para minimizar el sufrimiento: uno solo puede abstenerse de dañar a los humanos si reconoce los posibles daños y sabe cómo responder.[60]

Aplicación a las armas completamente autónomas.

Las armas completamente autónomas se enfrentarían a desafíos importantes para cumplir con el principio del trato humano porque la compasión y el juicio legal y ético son características humanas. La empatía y la compasión por los demás que engendra, vienen naturalmente a los seres humanos. La mayoría de los humanos han experimentado dolor físico o psicológico, lo que los impulsa a evitar infligir sufrimientos innecesarios a otros. Sus sentimientos trascienden las divisiones nacionales y otras. Como señala el CICR, “en todas las culturas se encuentran sentimientos y gestos de solidaridad, compasión y abnegación”.[61] La comprensión compartida del dolor y el sufrimiento de la gente los lleva a mostrar compasión por los demás seres humanos e inspira una reciprocidad que es, en palabras del CICR, “perfectamente natural”.[62]

Independientemente de la sofisticación de un arma completamente autónoma, no podría experimentar emociones.[63] Hay algunas ventajas asociadas a ser impermeable a emociones como la ira y el miedo, pero la incapacidad de un robot para sentir empatía y compasión limitaría gravemente su capacidad de tratar a los demás de forma humana. Como no serían seres sensibles, las armas completamente autónomas no podrían conocer el sufrimiento físico o psicológico. Como resultado, carecerían de las experiencias y entendimientos compartidos que causan que los humanos se relacionen de manera empática con el dolor de los demás, que sus “almas se agiten” y que sean impulsados a ejercer compasión hacia otros seres humanos. Amanda Sharkey, profesora de ciencias de la computación, ha escrito que “los robots actuales, que carecen de cuerpos vivos, no pueden sentir dolor, ni siquiera pueden preocuparse por sí mismos, y mucho menos extender esa preocupación a los demás. ¿Cómo pueden empatizar con el dolor o la angustia de un humano si no pueden experimentar alguna de las emociones?”[64] Por lo tanto, las armas completamente autónomas enfrentarían considerables dificultades para garantizar que sus actos sean humanos y que cumplan con los principios de la humanidad.

Los robots tampoco tendrían el juicio legal y ético necesario para minimizar el daño caso por caso.[65] Las situaciones que involucran el uso de la fuerza, particularmente en conflictos armados, son a menudo complejas e impredecibles y pueden cambiar rápidamente. Por lo tanto, las armas completamente autónomas encontrarían obstáculos significativos para tomar decisiones apropiadas con respecto a un trato humano. Después de examinar numerosos estudios en los que los investigadores intentaron programar la ética en robots, Sharkey descubrió que los robots que exhiben un comportamiento que podría describirse como “ético” o “mínimamente ético” podrían operar solo en entornos restringidos. Sharkey concluyó que los robots tienen capacidades morales limitadas y, por lo tanto, no deben usarse en circunstancias que “exijan competencia moral y una comprensión de la situación social que lo rodea”.[66] El cumplimiento del derecho internacional a menudo requiere la toma de decisiones subjetivas en situaciones complejas. Las armas completamente autónomas tendrían una capacidad limitada para interpretar los matices del comportamiento humano, comprender la dinámica política, socioeconómica y ambiental de la situación, y comprender los riesgos humanitarios del uso de la fuerza en un contexto particular.[67] Estas limitaciones comprometerían la capacidad de las armas para garantizar el trato humano a civiles y combatientes y cumplir con el primer principio de la humanidad.

Respeto por la vida humana y la dignidad.

Definición

Un segundo principio de la humanidad requiere que los actores respeten tanto la vida humana como la dignidad humana. Christof Heyns, Ex Relator Especial sobre Ejecuciones Extrajudiciales, Sumarias o Arbitrarias, destacó estos conceptos relacionados pero distintos cuando planteó dos preguntas con respecto a las armas completamente autónomas: “¿Permiten la selección apropiada?” e “incluso si ¿pueden hacer una orientación adecuada, deberían las máquinas tener el poder de la vida y la muerte sobre los humanos?”[68] El primero considera si un arma puede cumplir con las normas del derecho internacional sobre la protección de la vida. El segundo aborda la “manera de seleccionar objetivos” y si respeta la dignidad humana.[69]

Para respetar la vida humana, los actores deben tomar medidas para minimizar los asesinatos.[70] El derecho a la vida establece que “nadie será privado arbitrariamente de su vida”.[71] Limita el uso de la fuerza letal a circunstancias en las que es absolutamente necesario proteger la vida humana, constituye un último recurso y se aplica de manera proporcional a la amenaza.[72] Codificado en el artículo 6 del Pacto Internacional de Derechos Civiles y Políticos, el derecho a la vida ha sido reconocido como el “derecho supremo” del derecho internacional de los derechos humanos, que se aplica en todas las circunstancias. En tiempos de conflicto armado, el derecho internacional humanitario determina lo que constituye una privación de vida arbitraria o injustificada. Requiere que los actores cumplan con las reglas de distinción, proporcionalidad y necesidad militar en situaciones de conflicto armado.[73]

El juicio y la emoción promueven el respeto por la vida porque pueden servir como controles para matar. La capacidad de emitir juicios éticos y legales puede ayudar a un actor a determinar qué curso de acción protegerá mejor la vida humana en el número infinito de posibles escenarios imprevistos. Una resistencia instintiva a matar proporciona una motivación psicológica para cumplir y, a veces, ir más allá de las normas del derecho internacional para minimizar las víctimas.

Bajo los principios de la humanidad, los actores también deben respetar la dignidad de todos los seres humanos. Esta obligación se basa en el reconocimiento de que cada ser humano tiene un valor inherente que es universal e inviolable.[74] Numerosos instrumentos internacionales, entre ellos la Declaración Universal de Derechos Humanos, el Pacto Internacional de Derechos Civiles y Políticos, la Declaración y el Programa de Acción de Viena adoptados en la Conferencia Mundial de Derechos Humanos de 1993 y los tratados regionales, consagran la importancia de la dignidad como principio fundamental del derecho humanitario.[75] La Carta de África de Derechos Humanos y de los Pueblos establece explícitamente que las personas tienen “el derecho al respeto de la dignidad inherente a un ser humano”.[76]

Mientras que el respeto por la vida humana implica minimizar el número de muertes y evitar las arbitrarias o injustificadas, el respeto por la dignidad humana requiere una apreciación de la gravedad de la decisión de matar.[77] El CICR explicó que es importante “no solo si una persona muere o resulta herida, sino cómo la matan o lesionan, incluido el proceso por el que se toman estas decisiones”.[78] Antes de tomar una vida, un actor debe entender verdaderamente el valor de una vida humana y el significado de su pérdida. Los seres humanos deben ser reconocidos como individuos únicos y no reducidos a objetos con un valor meramente instrumental o sin valor.[79] Si un actor mata sin tener en cuenta el valor de la víctima individual, el asesinato socava la noción fundamental de la dignidad humana y viola este principio de la humanidad.

Aplicación a las armas completamente autónomas.

Es muy poco probable que las armas completamente autónomas puedan respetar la vida y la dignidad humanas. Su falta de juicio ético y legal interferiría con su capacidad de respetar la vida humana. Por ejemplo, la prueba de proporcionalidad del derecho internacional humanitario requiere que los comandantes determinen si la ventaja militar anticipada supera los daños civiles esperados caso por caso. Dado el número infinito de contingencias que pueden surgir en el campo de batalla, las armas completamente autónomas no podrían ser preprogramadas para hacer tales determinaciones. El estándar generalmente aceptado para evaluar la proporcionalidad es si un “comandante militar razonable” hubiera lanzado un ataque en particular[80] y la razonabilidad requiere tomar decisiones basadas en consideraciones éticas y legales.[81] Al no poder aplicar esta norma a la prueba de equilibrio de proporcionalidad, las armas completamente autónomas probablemente pondrían en peligro a los civiles y potencialmente violarían el derecho internacional humanitario.[82]

Las armas completamente autónomas también carecerían de la instintiva resistencia humana a matar que puede proteger la vida humana más allá de los requisitos mínimos de la ley.[83] La inclinación a evitar matar es algo natural para la mayoría de las personas porque tienen un aprecio innato por el valor inherente de la vida humana. La investigación empírica demuestra la reticencia de los seres humanos a tomar las vidas de otros humanos. Por ejemplo, un guardabosques del Ejército de los EE. UU. retirado que realizó una investigación exhaustiva sobre los asesinatos durante un conflicto armado descubrió que “existe en el hombre una resistencia intensa a matar a sus semejantes. Una resistencia tan fuerte que, en muchas circunstancias, los soldados en el campo de batalla morirán antes de que puedan superarla”.[84] Como objetos inanimados, las armas completamente autónomas no pueden perder su propia vida o comprender las emociones asociadas con la pérdida de la vida de un ser querido. Es dudoso que un programador pueda replicar en un robot la inclinación natural de un humano a evitar matar y proteger la vida con la complejidad y el matiz que reflejaría la toma de decisiones humana.

Las armas completamente autónomas no podrían respetar la dignidad humana, que se relaciona con el proceso que sucede por detrás, sino más bien con las consecuencias del uso de la fuerza.[85] Como máquinas, realmente no podrían comprender ni el valor de la vida individual, ni el significado de su pérdida. Basarían las decisiones de matar en algoritmos sin considerar la humanidad de una víctima específica.[86] Además, estas armas se programarían con antelación y no podrían explicar la necesidad de una fuerza letal en una situación específica. En una presentación de la CCAC como relator especial, Christof Heyns explicó que:

Permitir que las máquinas determinen cuándo y dónde usar la fuerza contra los humanos es reducir a esos humanos a objetos; son tratados como meros objetivos. Se convierten en ceros y unos en los ámbitos digitales de las armas que están programadas de antemano para liberar la fuerza sin la capacidad de considerar si no hay otra salida, sin un nivel suficiente de elección humana deliberada sobre el asunto.[87]

Mines Action Canada concluyó de manera similar que el “despliegue de armas completamente autónomas en combate, muestra la creencia de que cualquier humano atacado de esta manera no garantiza la consideración de un operador vivo, por lo tanto, le roba a la vida humana su derecho a la dignidad”.[88] Permitir que un robot tome una vida cuando no puede entender el valor inherente de esa vida o la necesidad de tomarla, no respeta y menosprecia a la persona cuya vida es tomada. Por lo tanto, es irreconciliable con los principios de humanidad consagrados en la Cláusula Martens.

Cuando se usa en situaciones apropiadas, la IA tiene el potencial de proporcionar beneficios extraordinarios a la humanidad. Sin embargo, permitir que los robots tomen decisiones para matar seres humanos sería contrario a la Cláusula Martens, que fusiona la ley y la moral. Las limitaciones en las capacidades emocionales, perceptivas y éticas de estas máquinas dificultan significativamente su capacidad para tratar a otros seres humanos con humanidad y respetar la vida y la dignidad humanas. En consecuencia, el uso de estas armas sería incompatible con los principios de humanidad establecidos en la Cláusula Martens.

V. Los dictados de la conciencia pública

La Cláusula Martens establece que, en ausencia de una ley de tratados, los dictados de la conciencia pública y los principios de la humanidad protegen a los civiles y los combatientes. La referencia a la "conciencia pública" inculca la ley en la moralidad y requiere que las evaluaciones de los medios y métodos de guerra tengan en cuenta las opiniones de los ciudadanos y los expertos, así como los gobiernos. Las reacciones de estos grupos ante la perspectiva de armas completamente autónomas dejan claro que el desarrollo, la producción y el uso de dicha tecnología plantearían serias preocupaciones en virtud de la Cláusula Martens.

Definición

Los dictados de la conciencia pública se refieren a pautas morales compartidas que dan forma a las acciones de los Estados y los individuos.[89] El uso del término “conciencia” indica que los dictados se basan en un sentido de moralidad, un conocimiento de lo que es correcto e incorrecto.[90] Según el filósofo Peter Asaro, la conciencia implica “sentirse obligado o creer en una obligación o deber moral específico”.[91] El adjetivo “público” aclara que estos dictados reflejan las preocupaciones de una variedad de personas y entidades. Sobre la base del trabajo ampliamente citado del jurista y experto en derecho internacional humanitario Theodor Meron, este informe analiza dos fuentes en particular para determinar qué califica como conciencia pública: la opinión del público y las opiniones de los gobiernos.[92]

Los datos de las encuestas y las opiniones de los expertos proporcionan evidencia de la opinión pública.[93] Las encuestas revelan las perspectivas y creencias de los individuos comunes y corrientes. También pueden iluminar diferencias matizadas en los valores y entendimientos de los laicos. Si bien las encuestas informativas, por sí mismas, no son medidas suficientes de la conciencia pública, en parte porque las respuestas pueden verse influidas por la naturaleza de las preguntas formuladas y no reflejan necesariamente la consideración moral.[94] Las declaraciones y acciones de los expertos, que a menudo han deliberado extensamente sobre estas cuestiones, reflejan una comprensión más profunda.[95] Su experiencia específica puede ir desde la religión hasta la tecnología y la ley, pero comparten un profundo conocimiento del tema. Las opiniones que expresan pueden así arrojar luz sobre las normas morales abrazadas por el público informado.[96]

Los gobiernos articulan sus posturas a través de políticas y en declaraciones escritas e intervenciones orales en reuniones diplomáticas y otros foros públicos. Sus posiciones reflejan las perspectivas de los países que difieren en el desarrollo económico, la destreza militar, los sistemas políticos, las tradiciones religiosas y culturales, y la demografía. La opinión del gobierno puede ayudar a iluminar opinio juris, un elemento del derecho internacional consuetudinario, que se refiere a la creencia de un Estado de que cierta práctica es legalmente obligatoria.[97]

Aplicación a las armas completamente autónomas

Las posiciones de individuos y gobiernos de todo el mundo han demostrado que las armas completamente autónomas son altamente problemáticas bajo los dictados de la conciencia pública. A través de encuestas de opinión, cartas abiertas, declaraciones orales y escritas, publicaciones detalladas y directrices autoimpuestas, los miembros del público han compartido su angustia y su indignación ante la perspectiva de estas armas. Funcionarios gubernamentales de más de 100 países han expresado preocupaciones similares y se han pronunciado a favor de imponer límites a las armas completamente autónomas.[98] Si bien la oposición pública a las armas completamente autónomas no es universal, colectivamente, estas voces muestran que es generalizada y creciente.[99]

Opinión del público

La oposición pública al desarrollo, producción y uso de armas completamente autónomas es significativa y se está extendiendo. Varias encuestas de opinión pública han revelado la resistencia de los individuos a estas armas.[100] Estos hallazgos se reflejan en declaraciones hechas por líderes en los campos relevantes de desarme y derechos humanos, paz y religión, ciencia y tecnología e industria. Si bien no son exhaustivas, las fuentes que se analizan a continuación ejemplifican la naturaleza y el rango de la opinión pública y proporcionan evidencia de la conciencia pública.

Encuestas

Las encuestas de opinión pública realizadas en todo el mundo han documentado una oposición generalizada al desarrollo, la producción y el uso de estas armas. De acuerdo con estas encuestas, la mayoría de las personas encuestadas encontraron inaceptable la posibilidad de delegar las decisiones de vida o muerte a las máquinas. Por ejemplo, una encuesta de estadounidenses realizada en 2013, realizada por la profesora de ciencias políticas Charli Carpenter, encontró que el 55% de los encuestados se oponía a la "tendencia a usar" armas completamente autónomas.[101] Esta posición se compartió aproximadamente de manera equitativa entre los géneros, las edades y las ideologías políticas. Curiosamente, el personal militar en servicio activo, que comprende de primera mano las realidades del conflicto armado, se encontraba entre los objetores más fuertes; el 73% expresó su oposición a las armas completamente autónomas.[102] La mayoría de los encuestados en esta encuesta también apoyaron una campaña para prohibir las armas.[103] Una encuesta nacional más reciente de alrededor de 1.000 belgas, que se publicó el 3 de julio de 2018, encontró que el 60% de los encuestados creía que “Bélgica debería apoyar los esfuerzos internacionales para prohibir el desarrollo, la producción y el uso de armas completamente autónomas”. Sólo el 23% en desacuerdo.[104]

Las encuestas de opinión internacionales han producido resultados similares. En 2015, Open Robotics Initiative encuestó a más de 1.000 personas de 54 países diferentes y descubrió que el 56% de los encuestados se oponía al desarrollo y uso de lo que denominó sistemas de armas autónomas letales.[105] El 34% de los encuestados rechazó el desarrollo y el uso porque “los humanos siempre deben ser los que toman decisiones de vida/muerte”.[106] Otras motivaciones citadas con menos frecuencia incluyen la falta de fiabilidad de las armas, el riesgo de proliferación y la falta de responsabilidad.[107] Una encuesta aún más grande realizada por Ipsos a 11.500 personas de 25 países, produjo resultados similares en 2017.[108] Esta encuesta explicó que las Naciones Unidas estaban revisando las "implicaciones estratégicas, legales y morales de los sistemas de armas autónomos" (equivalente a las armas totalmente autónomas) y preguntó a los participantes cómo se sentían con respecto al uso de las armas. El 56% registró su oposición.[109]

Organizaciones no gubernamentales y organizaciones internacionales

Al proporcionar evidencia adicional de inquietudes bajo los dictados de la conciencia pública, los expertos de diversos campos se han sentido obligados, especialmente por razones morales, a pedir la prohibición del desarrollo, la producción y el uso de armas completamente autónomas. La Campaña para Detener a los Robots Asesinos, una coalición de la sociedad civil de 75 ONG, encabeza el esfuerzo para prohibir las armas completamente autónomas.[110] Los miembros de sus ONG están activos en más de 30 países e incluyen grupos con experiencia en desarme humanitario, paz y resolución de conflictos, tecnología, derechos humanos y otros campos relevantes.[111] Human Rights Watch, que cofundó la campaña en 2012, es su coordinador. En los últimos seis años, las organizaciones miembro de la campaña han destacado los numerosos problemas asociados con las armas completamente autónomas a través de docenas de publicaciones y declaraciones realizadas en reuniones diplomáticas y eventos de las Naciones Unidas, en las redes sociales y en otros foros.[112]

Mientras que diferentes preocupaciones resuenan con diferentes personas, Steve Goose, director de la División de Armas de Human Rights Watch, destacó la importancia de la Cláusula Martens en su declaración en la reunión del Grupo de Expertos Gubernamentales de la CCAC de abril de 2018. Goose dijo:

Hay muchas razones para rechazar [los sistemas de armas autónomas letales] (incluidas las preocupaciones legales, de responsabilidad, técnicas, operativas, de proliferación y de seguridad internacional), pero las preocupaciones éticas y morales, que generan la sensación de repulsión, superan a todas. Estas preocupaciones éticas deberían obligar a las Altas Partes Contratantes de la Convención sobre Armas Convencionales a tener en cuenta la Cláusula Martens en el derecho internacional humanitario, según la cual no deben desarrollarse armas que vayan en contra de los principios de la humanidad y los dictados de la conciencia pública.[113]

El CICR ha alentado a los Estados a evaluar las armas completamente autónomas bajo la Cláusula Martens y observó que “con respecto a la conciencia pública, existe una profunda incomodidad con la idea de cualquier sistema de armas que ponga el uso de la fuerza más allá del control humano”.[114] El CICR ha enfatizado repetidamente la necesidad ética y legal del control humano sobre las funciones críticas de selección y ataque de objetivos. En abril de 2018, dejó en claro su opinión de que “se requiere un nivel mínimo de control humano para garantizar el cumplimiento de las normas del derecho internacional humanitario que protegen a los civiles y combatientes en conflictos armados, y la aceptabilidad ética en términos de los principios de humanidad y conciencia pública”.[115] El CICR explicó que el derecho internacional humanitario “exige que aquellos que planifican, deciden y llevan a cabo ataques hacen ciertos juicios al aplicar las normas al lanzar un ataque. Las consideraciones éticas son paralelas a este requisito: exigir que la agencia y la intención humanas se mantengan en las decisiones de usar la fuerza”.[116] El CICR concluyó que un sistema de armas fuera del control humano “sería ilegal por su propia naturaleza”.[117]

Líderes de paz y fe

En 2014, más de 20 individuos y organizaciones que habían recibido el Premio Nobel de la Paz emitieron una carta conjunta en la que declaraban que “abrazan de todo corazón [el] objetivo de una prohibición preventiva de armas completamente autónomas” y consideran que “es inconcebible que los seres humanos sigan expandiendo la investigación y el desarrollo de máquinas letales que podrían matar personas sin intervención humana”.[118] Los firmantes individuales de la carta incluían a la activista estadounidense Jody Williams, quien dirigió la campaña de la sociedad civil para prohibir las minas terrestres, junto con jefes de Estado y políticos, activistas por los derechos humanos y por la paz, un abogado, un periodista y un líder de la iglesia.[119] Los signatarios de la organización, las Conferencias Pugwash sobre Ciencia y Asuntos Mundiales y la Iniciativa Nobel de Mujeres, que ayudaron a encabezar la carta, están en el comité directivo de la Campaña para Detener a los Robots Asesinos.

Los líderes religiosos se han unido de manera similar contra las armas completamente autónomas. En 2014, más de 160 líderes religiosos firmaron una “declaración interreligiosa que pide a los Estados que trabajen para lograr una prohibición global de las armas completamente autónomas”.[120] En un lenguaje que implica preocupaciones bajo los principios de la humanidad, la declaración describe tales armas como “una afrenta a la dignidad humana y al carácter sagrado de la vida”.[121] La declaración además critica la idea de delegar decisiones de vida o muerte a una máquina porque las armas completamente autónomas no tienen “agencia moral y, como resultado, no pueden ser consideradas responsables si toman una vida inocente”.[122] La lista de firmantes incluía representantes del budismo, el catolicismo, el islamismo, el judaísmo, el protestantismo y el cuakerismo. El arzobispo Desmond Tutu firmó esta declaración y la carta de los Premios Nobel de la Paz.

Expertos en ciencia y tecnología

Los individuos con experiencia tecnológica también han expresado su oposición a las armas completamente autónomas. El Comité Internacional para el Control de Armas Robóticas (ICRAC, por sus siglas en inglés), cuyos miembros estudian la tecnología de varias disciplinas, dio la alarma en 2013 poco después de cofundar la Campaña para Detener los Robots Asesinos.[123] El ICRAC emitió una declaración respaldada por más de 270 expertos que piden una prohibición del desarrollo y despliegue de armas completamente autónomas.[124] Los miembros del ICRAC señalaron “la ausencia de evidencia científica clara de que las armas de robot tienen, o es probable que tengan en el futuro previsible, la funcionalidad requerida para la identificación precisa de los objetivos, la conciencia de la situación o las decisiones sobre el uso proporcional de la fuerza” y concluyeron que “las decisiones sobre la aplicación de la fuerza violenta no deben delegarse en las máquinas”.[125] Si bien las preocupaciones enfatizadas en esta declaración se centran en la tecnología, como se discutió anteriormente, la incapacidad para tomar decisiones de proporcionalidad puede ir en contra del respeto por la vida y los principios de la humanidad.

En 2015, un grupo aún mayor de investigadores de inteligencia artificial y robótica emitió una carta abierta. A partir de junio de 2018, más de 3.500 científicos junto a más de 20.000 otras personas firmaron este llamado a una prohibición.[126] La carta advierte que estas máquinas podrían convertirse en los “Kalashnikov del mañana” si no se evita su desarrollo.[127] Afirma que mientras los firmantes “creen que la IA tiene un gran potencial para beneficiar a la humanidad de muchas maneras (…) creen que una carrera de armamentos de la IA militar no sería beneficiosa para la humanidad. Hay muchas maneras en que la IA puede hacer que los campos de batalla sean más seguros para los humanos, especialmente los civiles, sin crear nuevas herramientas para matar gente”.[128]

Además de exigir la acción de otros, miles de expertos en tecnología se han comprometido a no participar en acciones que promuevan el desarrollo de armas completamente autónomas. En un congreso mundial celebrado en Estocolmo en julio de 2018, los principales investigadores de Amnistía Internacional emitieron una promesa de “no participar ni apoyar el desarrollo, la fabricación, el comercio o el uso de armas autónomas letales”.[129] A finales de mes, más de 2.850 expertos en inteligencia artificial, científicos y otras personas, junto con 223 compañías de tecnología, sociedades y organizaciones de al menos 36 países habían firmado. El compromiso, que cita preocupaciones morales, de rendición de cuentas, de proliferación y relacionadas con la seguridad, encuentra que “la decisión de tomar una vida humana nunca debe delegarse en una máquina”. Afirma: “Hay un componente moral en esta posición, por lo que no debemos permitir que las máquinas tomen decisiones para tomar vidas por las cuales otros, o nadie, serán culpables”.[130] De acuerdo con el Future of Life Institute, que alberga el compromiso en su sitio web, el compromiso es necesario porque “los políticos hasta ahora no han puesto en práctica” ninguna regulación y ley contra los sistemas de armas autónomos letales.[131]

Industria

Las empresas de tecnología de alto perfil y sus representantes han criticado las armas completamente autónomas por varios motivos. Un fabricante canadiense de robótica, ClearPath Robotics, se convirtió en la primera compañía que se negó públicamente a fabricar "robots armados que sacan la supervisión humana”.[132] En 2014, se comprometió a “valorar la ética sobre los posibles ingresos futuros”.[133] En una carta al público, la compañía declaró que estaba motivada por su creencia de que “el desarrollo de robots asesinos no es prudente, no es ético y debería ser prohibido a escala internacional”. ClearPath continuó:

¿Podría un robot tener la moral, el sentido o la comprensión emocional para intervenir en contra de órdenes que son incorrectas o inhumanas? No. ¿Podrían las computadoras tomar los tipos de decisiones subjetivas necesarias para verificar la legitimidad de los objetivos y garantizar el uso proporcional de la fuerza en el futuro previsible? No. ¿Podría esta tecnología llevar a los que la poseen a valorar menos la vida humana? Francamente, creemos que este será el caso.[134]

La carta muestra que las armas completamente autónomas plantean problemas bajo los principios de la humanidad y los dictados de la conciencia pública.

En agosto de 2017, los fundadores y directores ejecutivos (CEO) de 116 empresas de inteligencia artificial y robótica publicaron una carta en la que pedían a los Estados miembro de la CCAC que tomaran medidas sobre las armas autónomas.[135] La carta comienza diciendo: “Como compañías que desarrollan tecnologías en inteligencia artificial y robótica que pueden ser reutilizadas para desarrollar armas autónomas, nos sentimos especialmente responsables de dar esta alarma”.[136] La carta continúa destacando los peligros para los civiles, el riesgo de una carrera de armamentos y la posibilidad de efectos desestabilizadores. Advierte que “una vez que se abra la caja de Pandora, será difícil cerrarla”.[137] En una línea similar en 2018, Scott Phoenix, CEO de Vicarious, una importante compañía de desarrollo de inteligencia artificial, describió el desarrollo de armas autónomas como una de las “peores ideas del mundo” debido a la probabilidad de defectos en sus códigos y la vulnerabilidad a la piratería.[138]

Google y las compañías de su grupo Alphabet han estado en el centro del debate sobre armas completamente autónomas en múltiples ocasiones. DeepMind es una compañía de investigación de inteligencia artificial que fue adquirida por Google en 2014. En 2016, presentó pruebas a un comité parlamentario del Reino Unido en el que describió una prohibición de las armas autónomas como “el mejor enfoque para evitar las consecuencias perjudiciales que surgirían del desarrollo y uso de tales armas”.[139] DeepMind expresó una preocupación particular por las “implicaciones de las armas para la estabilidad global y la reducción de conflictos”.[140] Dos años después, más de 3.000 empleados de Google protestaron por la participación de la compañía en el “Proyecto Maven”, un programa del Departamento de Defensa de los EE. UU., que pretende utilizar la IA para procesar de forma autónoma las imágenes de video tomadas por drones de vigilancia. Los empleados argumentaron que la compañía “no debería estar en el negocio de la guerra”[141] y más de 1.100 académicos los apoyaron en una carta separada.[142] En junio de 2018, Google acordó finalizar su participación en el Proyecto Maven una vez que el contrato expire en 2019 y emitió principios éticos comprometiéndose a no desarrollar IA para el uso en armas. Los principios establecen que Google “no está desarrollando IA para su uso en armas” y “no diseñará ni desplegará IA” para tecnología que cause “daños generales” o “contravenga principios ampliamente aceptados del derecho internacional y los derechos humanos”.[143]

Los inversores en la industria de la tecnología también han comenzado a responder a las preocupaciones éticas planteadas por las armas completamente autónomas. En 2016, el Consejo de Ética del Fondo de Pensiones del Gobierno de Noruega anunció que vigilaría las inversiones en el desarrollo de estas armas para decidir si son contrarias a las directrices del consejo.[144] Johan H. Andresen, presidente del consejo, reiteró esa posición en una presentación de panel para delegados de la CCAC en abril de 2018.[145]

Opiniones de gobiernos

Los gobiernos de todo el mundo han compartido cada vez más las opiniones de los expertos y el público en general de que el desarrollo, la producción y el uso de armas sin un control humano significativo es inaceptable. A partir de abril de 2018, 26 naciones —de África, Asia, Europa, América Latina y Oriente Medio— han pedido una prohibición preventiva de armas completamente autónomas.[146] Además, más de 100 Estados, incluidos los del Movimiento de Países No Alineados (MPNA), han pedido un instrumento legalmente vinculante para tales armas. En una declaración conjunta, los miembros de MPNA citaron “cuestiones éticas, legales, morales y técnicas, así como internacionales relacionadas con la paz y la seguridad” como temas de preocupación.[147] Si bien un análisis completo de las intervenciones gubernamentales en los últimos cinco años está más allá del alcance de este informe, en general, las declaraciones han demostrado que los países se oponen a la pérdida del control humano por motivos morales, legales, técnicos y otros. Las opiniones de estos gobiernos, que reflejan las preocupaciones del público, refuerzan el argumento de que las armas completamente autónomas violan los dictados de la conciencia pública.

Los principios incorporados en la Cláusula Martens han desempeñado un papel en las discusiones internacionales sobre armas completamente autónomas desde su inicio en 2013. En ese año, Christof Heyns, el entonces Relator Especial sobre Ejecuciones Extrajudiciales, presentó un informe al Consejo de Derechos Humanos de la ONU sobre armas completamente autónomas, a las que denominó “robótica autónoma letal”.[148] Al enfatizar la importancia del control humano sobre las decisiones de vida o muerte, Heyns explicó que “es un supuesto subyacente de la mayoría de los códigos legales, morales y de otra índole que cuando la decisión de quitar la vida o de someter a las personas a otras graves consecuencias es en juego, el poder de decisión debe ser ejercido por los humanos”.[149] Continuó: “Delegar este proceso deshumaniza aún más el conflicto armado y excluye un momento de deliberación en aquellos casos en que sea posible. Las máquinas carecen de moralidad y mortalidad, y como resultado no deben tener poderes de vida o muerte sobre los humanos”.[150] Heyns también nombró la Cláusula Martens como una base legal para su determinación.[151] El informe de 2013 pedía una moratoria sobre el desarrollo de armas completamente autónomas hasta el establecimiento de un “marco acordado internacionalmente”.[152] Un informe conjunto de 2016 de Heyns y Maina Kiai, el entonces Relator Especial de las Naciones Unidas sobre la Libertad de Reunión Pacífica y de Asociación, dio un paso más y recomendó que “deben prohibirse los sistemas de armas autónomos que no requieren un control humano significativo”.[153]

En mayo de 2013, en respuesta al informe de Heyns, el Consejo de Derechos Humanos de la ONU celebró las primeras discusiones sobre las armas a nivel internacional.[154] De las 20 naciones que expresaron sus posiciones, muchas expresaron inquietudes acerca de la tecnología emergente. A menudo usaban lenguaje relacionado con la Cláusula Martens o la moralidad en general. Ecuador se refirió explícitamente a los elementos de la Cláusula Martens y declaró que dejar las decisiones de vida o muerte a las máquinas sería una violación de la conciencia pública.[155] Indonesia planteó objeciones relacionadas con los principios de humanidad discutidos anteriormente. Criticó los “posibles efectos de largo alcance en los valores de la sociedad, incluso fundamentalmente en la protección y el valor de la vida” que podrían surgir del uso de estas armas.[156] Rusia recomendó que se preste “atención particular” a las “graves implicaciones para los fundamentos sociales, incluida la negación de la vida humana”.[157] Pakistán pidió una prohibición basada en el precedente de la prohibición preventiva de los láseres cegadores, que fue motivada en gran parte por la Cláusula Martens.[158] Brasil también abordó temas de moralidad; dijo: “Si la muerte de un ser humano por otro ha sido un desafío que los códigos legales, morales y religiosos han lidiado desde tiempos inmemoriales, uno puede imaginar la cantidad de preocupaciones adicionales que plantean los robots que ejercen el poder de la vida y la muerte sobre los humanos”.[159] Si bien los Estados miembros del Consejo de Derechos Humanos también abordaron otros riesgos importantes de armas completamente autónomas, especialmente las relacionadas con la seguridad, la moralidad fue un tema dominante.[160]

Desde la sesión del Consejo de Derechos Humanos en 2013, la mayoría de las discusiones diplomáticas han tenido lugar bajo los auspicios de la Convención sobre Armas Convencionales.[161] Los Estados parte de la Convención celebraron tres reuniones informales de expertos sobre lo que denominan “sistemas de armas autónomas letales” entre 2014 y 2016.[162] En su Conferencia de Revisión de 2016, acordaron formalizar las discusiones en un Grupo de Expertos Gubernamentales, un foro que generalmente se espera que produzca un resultado tal como un nuevo protocolo de la CCAC[163] Más de 80 estados participaron en la reunión más reciente del grupo en abril de 2018. En esa reunión, Austria observó que “el compromiso de la CCAC con armas autónomas letales es un testimonio del alto nivel de preocupación sobre el riesgo que conllevan dichas armas”.[164] También sirve como una indicación de que la conciencia pública está en contra de esta tecnología.

Los Estados parte de la CCAC han destacado la relevancia de la Cláusula Martens en cada una de sus reuniones sobre sistemas de armas autónomos letales. En la primera reunión celebrada en mayo de 2014, por ejemplo, Brasil describió la Cláusula Martens como una “piedra angular” del derecho internacional humanitario, que “nos permite navegar de manera segura en aguas nuevas y peligrosas y sentirnos seguros de que un ser humano sigue estando protegido. Los principios de la humanidad y los dictados de la conciencia pública”.[165] México encontró que “no hay ninguna duda de que el desarrollo de estas nuevas tecnologías debe cumplir con los [principios] de la Cláusula Martens”.[166] En la segunda reunión de expertos de la CCAC en abril de 2015, Rusia describió la Cláusula Martens como “una parte integral del derecho internacional consuetudinario”.[167] Al adoptar una interpretación estricta de la disposición, los Estados Unidos dijeron que “la Cláusula Martens no es una norma de derecho internacional que prohíba cualquier arma en particular, mucho menos un arma que no existe actualmente”. Sin embargo, reconoció que “los principios de la humanidad y los dictados de la conciencia pública proporcionan un paradigma relevante e importante para discutir las cuestiones morales o éticas relacionadas con el uso de la automatización en la guerra”.[168]

Varios Estados miembro de la CCAC han basado sus objeciones a las armas completamente autónomas en la Cláusula Martens y sus elementos. En una declaración conjunta en abril de 2018, el Grupo Africano dijo que los “principios de humanidad y los dictados de la conciencia pública enunciados en la Cláusula [Martens] deben tomarse en serio”.[169] El Grupo Africano pidió una prohibición preventiva de los sistemas de armas autónomas letales, declarando que sus miembros encontraron “inhumano, aborrecible, repugnante y contra la conciencia pública que los humanos entreguen el control a las máquinas, permitiendo que las máquinas decidan quién vive o muere, cómo muchas vidas y cuya vida es aceptable como daño colateral cuando se usa la fuerza”.[170] La Santa Sede condenó las armas completamente autónomas porque “nunca podrían ser un sujeto moralmente responsable. La capacidad humana única para el juicio moral y la toma de decisiones éticas es más que una compleja colección de algoritmos y dicha capacidad no puede ser reemplazada ni programada en una máquina”. La Santa Sede advirtió que los sistemas de armas autónomos podrían ser normales y aceptables “aquellos comportamientos que el derecho internacional prohíbe, o que, aunque no se explican de manera explícita, todavía están prohibidos por dictámenes de moralidad y conciencia pública”.[171]

En la reunión de abril de 2018, otros Estados plantearon asuntos de manera más implícita bajo la Cláusula Martens. Grecia, por ejemplo, declaró que “es importante garantizar que los comandantes y operadores se mantendrán al tanto del proceso de toma de decisiones para garantizar el juicio humano apropiado sobre el uso de la fuerza, no solo por razones relacionadas con la responsabilidad, sino principalmente proteger la dignidad humana sobre la decisión de vida o muerte”.[172]

En los últimos cinco años, los Estados parte de la CCAC han considerado una serie de otros problemas relacionados con los sistemas de armas autónomas letales. Han resaltado, entre otras cosas, los desafíos de cumplir con el derecho internacional humanitario y las normas internacionales de derechos humanos, el potencial de vacío en la rendición de cuentas, el riesgo de una carrera de armamentos y un umbral más bajo para la guerra, y la vulnerabilidad de las armas a la piratería. Combinados con la Cláusula Martens, estos problemas han llevado a la convergencia de puntos de vista sobre el imperativo de retener alguna forma de control humano sobre los sistemas de armas mediante el uso de la fuerza. En abril de 2018, Pakistán señaló que “se está desarrollando un sentido general entre las Altas Partes Contratantes de que las armas con funciones autónomas deben permanecer bajo el control directo y la supervisión de los seres humanos en todo momento, y deben cumplir con el derecho internacional”.[173] De manera similar, la Unión Europea declaró que sus miembros “creen firmemente que los humanos deben tomar las decisiones con respecto al uso de la fuerza letal, ejercer un control suficiente sobre los sistemas de armas letales que utilizan y seguir siendo responsables de las decisiones sobre la vida y la muerte”.[174]

El año 2018 también ha visto un aumento en los pedidos parlamentarios y de las Naciones Unidas para el control humano. El 4 de julio, el comité de defensa del Parlamento belga adoptó una resolución solicitando al gobierno que apoye los esfuerzos internacionales para prohibir el uso de armas completamente autónomas.[175] Al día siguiente, el Parlamento Europeo votó para recomendar que el Consejo de Seguridad de la ONU:

Trabajar para lograr una prohibición internacional de los sistemas de armas que carecen del control humano sobre el uso de la fuerza según lo solicitado por el Parlamento en diversas ocasiones y, en preparación de las reuniones pertinentes a nivel de las Naciones Unidas, desarrollar y adoptar urgentemente una posición común sobre los sistemas de armas autónomos y hablar en los foros relevantes con una sola voz y actuar en consecuencia.[176]

En su agenda de desarme de 2018, el secretario general de la ONU señaló: “Todas las partes parecen estar de acuerdo en que, como mínimo, es necesaria la supervisión humana sobre el uso de la fuerza”. Se ofreció a apoyar los esfuerzos de los Estados “para elaborar nuevos medidas, incluso a través de acuerdos políticamente o legalmente vinculantes, para garantizar que los seres humanos permanezcan en todo momento en control sobre el uso de la fuerza”.[177] Si bien el término queda por definir, requerir “control humano” es efectivamente lo mismo que prohibir las armas sin tal control. Por lo tanto, el acuerdo generalizado sobre la necesidad del control humano indica que las armas completamente autónomas contravienen los dictados de la conciencia pública.