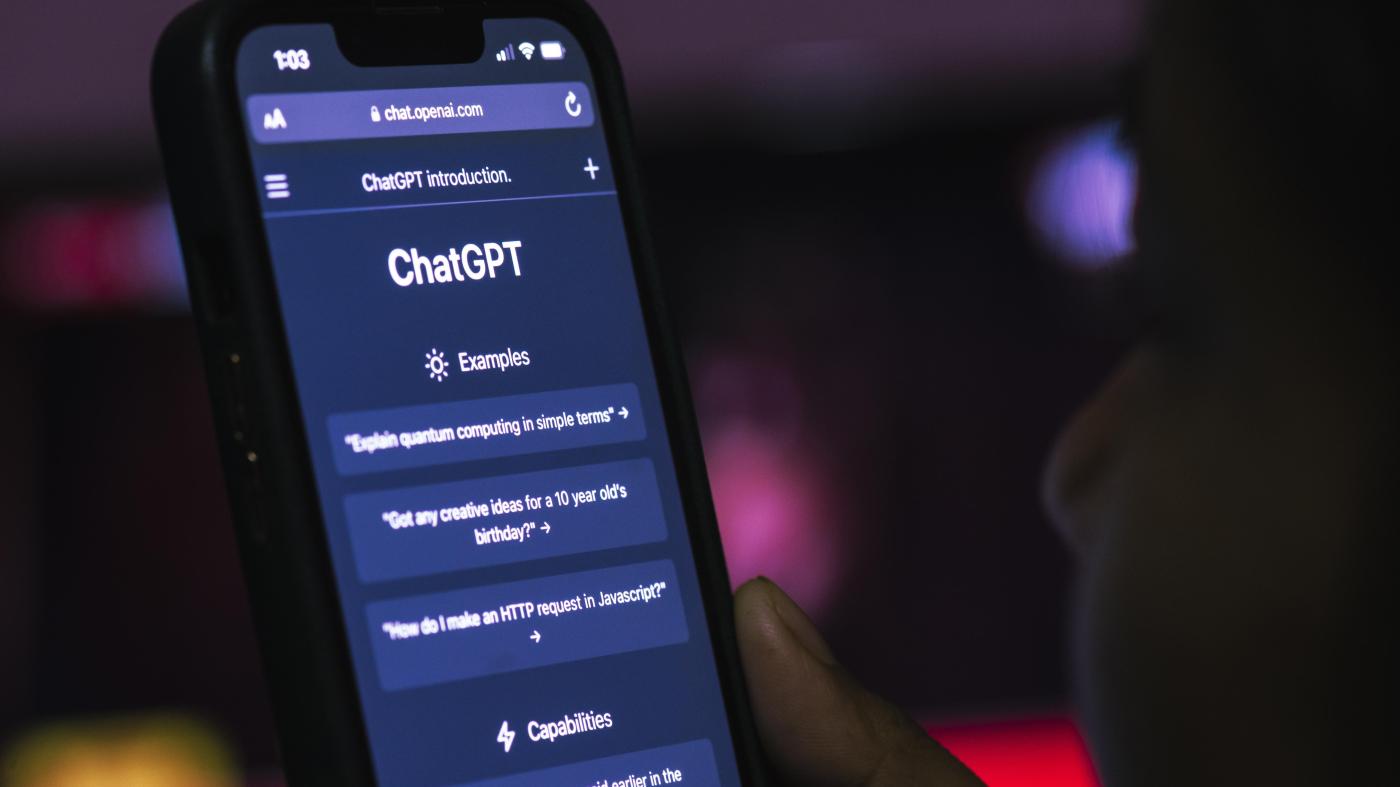

Que sont l’IA générative et ChatGPT ?

ChatGPT est une technologie connue sous le nom d’« IA générative ». L’IA générative est une technologie de pointe qui permet aux utilisateurs de générer de nouveaux contenus – mots, images et maintenant même vidéos – en saisissant un message dans un système qui le guide pour créer un résultat spécifique.

ChatGPT, qui est sans doute le plus connu des produits d’IA générative, a été développé par la société technologique californienne OpenAI. Depuis qu’OpenAI a lancé ChatGPT en novembre 2022, la course à l’IA générative est lancée. De nombreuses entreprises technologiques, dont Google, Amazon et Baidu, ont depuis lancé leurs propres produits d’IA générative. Microsoft a investi des milliards dans OpenAI et utilise ChatGPT dans une version générative de son moteur de recherche, Bing. Elon Musk se préparerait également à lancer une nouvelle entreprise dédiée à l’IA générative.

Il faut noter que de manière générale, seules les grandes entreprises ou les entreprises exceptionnellement bien financées peuvent concevoir ces produits en raison des ressources financières et techniques importantes requises pour les fabriquer et les exploiter, notamment l’accès à d’énormes quantités de données et de puissance de calcul. L’IA générative, si elle préfigure l’avenir, est une vision proposée et réalisée par une poignée d’entreprises technologiques et d’individus très puissants, qui chacun défendent leurs propres intérêts commerciaux. Cela soulève d’importantes questions sur le pouvoir et la responsabilité des entreprises.

De quoi se nourrit l’IA générative ?

Les modèles d’IA générative apprennent grâce à de grandes quantités de données. Cela pose problème lorsque les données et processus de développement de ces modèles ne sont pas accessibles au public, comme c’est le cas pour GPT4, le dernier produit d’IA générateur d’images et de texte conçu par OpenAI. Nous savons que GPT3, le précédent modèle d’OpenAI, a appris à partir de textes extraits d’un grand nombre de sources Internet, notamment les forums Reddit.

L’utilisation de milliards d’images et de textes provenant d’Internet et utilisés comme données d’apprentissage, sans filtrage minutieux ni modération rigoureuse, risque de perpétuer les pires problèmes liés aux contenus que nous observons déjà en ligne, comme la présentation d’opinions sous forme de faits, la création de fausses images ou vidéos rendues crédibles, le renforcement des préjugés structurels et la production de contenus nuisibles et discriminatoires, pour n’en citer que quelques-uns.

Les recherches montrent que le contenu d’Internet n’est tout simplement pas représentatif de la réalité vécue par la plupart des gens. Par exemple, Wikipédia a toujours une tendance à présenter majoritairement des informations sur les hommes, et sur ce que l’on appelle le Nord global, malgré les efforts considérables déployés pour remédier aux inégalités de contenu. Les systèmes d’IA générative qui apprennent grâce à des données non représentatives ne font que reproduire les inégalités du contenu qui existe sur Internet.

Le fait pour les entreprises de récupérer les contenus des individus à leur insu ou sans leur consentement pour les utiliser comme des données d’apprentissage a par ailleurs des implications évidentes en matière de protection de la vie privée. Comment savoir si votre image ou votre texte a été utilisé pour l’apprentissage d’un système d’IA générative ? Comment demander à ce qu’il soit retiré du système ?

En quoi cette technologie diffère-t-elle de ce qui est déjà disponible en ligne ?

C’est la première fois que des applications avancées et créatives de l’IA sont accessibles à toute personne possédant un ordinateur ou un smartphone. Mais les applications d’IA génératrices de textes et d’images sont encore massivement dominées par la langue anglaise, ce qui limite considérablement l’accessibilité à cet égard.

Human Rights Watch travaille sur l’impact de l’IA sur les droits humains depuis cinq ans, et l’IA générative est à bien des égards une extension des préoccupations bien connues concernant l’IA et la technologie d’apprentissage automatique – qu’il s’agisse du risque accru de surveillance, de discrimination, ou du manque d’obligation de rendre des comptes quand les choses tournent mal.

Quels sont les risques liés à la protection de la vie privée et à la sécurité des données ?

Faites attention à ce que vous tapez dans les outils d’IA générative ! Il nous faut partir du principe que tout ce que nous saisissons dans ces produits est, dans une certaine mesure, utilisé pour permettre au modèle d’apprendre et de « s’améliorer », et est visible pour l’entreprise technologique qui possède ou utilise le système. Dans plusieurs secteurs déjà, les entreprises demandent à leur personnel de ne pas saisir d’informations sensibles ou personnelles dans les systèmes d’IA générative.

Même lorsque nous saisissons des informations apparemment banales dans des moteurs de recherche ou des chatbots d’IA générative, ces informations pourraient être utilisées pour dresser notre portrait. L’IA est particulièrement douée pour reconnaître les routines ou les habitudes, et ce que nous recherchons ou tapons dans les chatbots pourrait, au fil du temps, révéler des informations sensibles sur notre identité ou nos comportements, à partir de contenus qu’en temps normal, nous ne jugerions pas comme des informations particulièrement révélatrices sur nous-mêmes.

À l’heure actuelle, nous manquons d’informations pour savoir dans quelle mesure nos données sont utilisées et peuvent être associées à des identités individuelles. Nous avons besoin de réponses de la part des entreprises technologiques sur la manière dont elles respecteront les droits à la vie privée s'agissant de l’IA générative. Il convient de noter qu’OpenAI a renforcé les contrôles de confidentialité de ChatGPT il y a quelques jours, après l’interdiction de son produit en Italie pour des raisons de protection des données. Il s’agit d’un paysage en pleine évolution.

S’agit-il de systèmes fiables ?

Il est clair que nous ne pouvons pas attacher trop d’importance à des systèmes dont on sait qu’ils contiennent des faussetés et des inexactitudes, en particulier lorsque leur conception est opaque. Le chatbot de Google, Bard, a par exemple donné une réponse contenant une erreur factuelle lors de son lancement. Il suffirait de faire une recherche Google pour trouver la bonne réponse, même s’il faudrait peut-être passer en revue plusieurs mauvaises réponses avant de trouver la bonne. Mais avec certains systèmes d’IA générative, il n’est pas facile d’identifier les sources d’information, qui aident les gens à évaluer de manière critique s’ils doivent faire confiance au résultat.

Les chatbots d’IA générative posent d’ailleurs d’autres problèmes de sécurité, car leur conception et leur ton conversationnel peuvent leur donner l’air de faire autorité et de ressembler à un être humain. Cela peut conduire les utilisateurs à leur accorder une confiance excessive.

Les conséquences sont graves. Il y a le cas de ce juge colombien qui a déclaré avoir interrogé ChatGPT lors de la préparation d’un jugement. Dans quelle mesure cette technologie peut-elle influencer une décision de justice ? En Belgique, une femme affirme que son mari s’est suicidé à la suite de ses interactions avec un chatbot d’IA générative.

Il faut que les concepteurs de ces technologies et les régulateurs fassent une pause et réfléchissent à certaines des grandes questions qui se posent à eux : Comment ces technologies pourraient-elles être utilisées à mauvais escient ? Même avec les meilleures intentions, qu’est-ce qui pourrait mal tourner ? Cela pourrait-il être préjudiciable et, si c’est le cas, que pouvons-nous faire ?

Les entreprises s’empressent de mettre sur le marché des produits qui ne sont manifestement pas sûrs pour un usage général. Les premières versions des chatbots d’IA générative ont produit des résultats problématiques et biaisés. Nous savons que la concurrence actuelle dans cette industrie alimente une course vers le bas, plutôt qu’une course fondée sur des politiques et des pratiques conformes aux droits humains.

Les entreprises technologiques ont des responsabilités en matière de droits humains, qui sont d’autant plus importantes quand elles sont à l’origine de nouvelles technologies à la fois puissantes et exploratoires. Elles doivent montrer clairement qu’elles identifient et sont prêtes à atténuer les risques en matière de droits humains avant la mise sur le marché de leurs produits. Elles doivent également être tenues pour responsables de tout préjudice causé par eux. Pour ce faire, les données d'apprentissage, les valeurs utilisées dans la conception des modèles et les processus de modération des contenus doivent tous faire l’objet d’un examen indépendant.

Il semble que la désinformation puisse être omniprésente avec cette technologie. Êtes-vous inquiète à ce sujet ?

Cela risque en effet d’être un gros problème. L’IA générative pourrait changer radicalement notre façon d’utiliser Internet en modifiant la manière dont nous trouvons les informations en ligne et dont nous nous y fions. Comment se fier à ce que l’on voit ? Avec des développements tels que les modèles texte-image et texte-vidéo, nous ouvrons la boîte de Pandore de la confiance dans le contenu même d’Internet. Nous avons déjà du mal à savoir ce qui est réel, et ce problème est sur le point de s’aggraver. Cela peut avoir des conséquences dévastatrices, par exemple lors d’événements politiques tels que des élections ou dans des situations de conflit et de crise.

Il existe des chatbots d’IA générative qui se font passer pour des personnages historiques ou des responsables politiques. Des personnes pourraient publier des textes qui, s’ils étaient pris au sérieux, pourraient être utilisés pour blanchir des crimes graves et des violations des droits humains.

Qu’en est-il de ceux qui passent au crible les données pour alimenter ces chatbots ?

La construction d’une IA nécessite beaucoup de travail humain invisible. Une personne doit étiqueter les données d’apprentissage et une autre décider si la machine fait bien ou mal les choses. Ce processus repose sur la saisie d’informations par des humains, ce qui signifie que la technologie comporte inévitablement des biais humains.

L’exploitation de travailleurs lors de la création de l’IA est une autre question clé en matière de droits humains. Une enquête de Time Magazine a montré comment OpenAI avait externalisé l’étiquetage de ses données pour ChatGPT à Sama, une entreprise qui a employé dans des conditions éprouvantes des travailleurs au Kenya, dont certains étaient payés moins de 2 dollars de l’heure pour passer au crible des données toxiques et biaisées.

Les entreprises technologiques externalisent cette main-d'œuvre dans les pays du Sud. Le fossé entre les conditions de travail dans les sièges des entreprises technologiques américaines et dans les lieux qui alimentent ces technologies est immense. Les travailleurs qui construisent l’IA sont souvent les témoins des pires aspects d’Internet, et ils méritent mieux. Toutes les entreprises ont la responsabilité de garantir un salaire décent et la dignité au travail.

Quels types de réglementations existent pour contrôler cette technologie ?

Les entreprises technologiques ont tenté de devancer la réglementation en essayant de s’autoréguler, par exemple en rédigeant et en adoptant des principes ou des lignes directrices qu’elles s’imposeraient théoriquement à elles-mêmes. Dans le cadre de ses principes en matière d’IA, par exemple, Google a déclaré qu’il ne mettrait pas sur le marché des produits d’IA dont la finalité est contraire aux droits humains. Mais attendre des entreprises technologiques qu’elles suivent les principes qu’elles se fixent pour elles-mêmes, c’est donner trop de confiance à l’autogouvernance. L’IA est bien trop puissante et les conséquences pour les droits sont trop graves pour que les entreprises parviennent à s’autoréguler.

Toutes les entreprises ont une responsabilité s’agissant du respect des normes en matière de droits humains et des mesures qu’elles prennent pour identifier, prévenir et atténuer les risques qu’elles peuvent causer en matière de droits humains, ceux auxquels elles contribuent ou ceux auxquels elles sont liées dans le cadre de leurs activités propres ou de celles de leur chaîne de valeur. Ces responsabilités sont énoncées dans les Principes directeurs des Nations Unies relatifs aux entreprises et aux droits de l’homme, ainsi que dans les lignes directrices de l’Organisation de coopération et de développement économiques. Nous devons traduire les principes directeurs des Nations Unies en lois contraignantes, non seulement pour l’IA, mais pour toutes les technologies.

Ces dernières années, les législateurs ont éprouvé des difficultés à suivre le rythme des développements de l’industrie des nouvelles technologies, mais nous assistons aujourd’hui à l’émergence d’une réglementation de l’IA aux niveaux national et régional. L’une des plus importantes est la loi sur l’IA de l’Union européenne, qui a fait l’objet d’un premier vote ces dernières semaines, avec la proposition de traiter des questions de droits d’auteur dans l’IA générative. Nous verrons si cela va assez loin pour répondre aux préoccupations soulevées par cette technologie en matière de droits humains.

Quel est l’impact de cette technologie sur les enquêtes menées en matière de droits humains ?

Les organisations de défense des droits humains ont un rôle important à jouer en exposant et en contestant la manière dont les technologies émergentes sont développées, notamment s’agissant des produits qui utilisent l’IA générative.

Mais l’IA générative représente aussi une menace bien réelle pour les enquêtes qui sont menées sur les questions de droits humains. Les progrès de cette technologie signifient qu’il est désormais possible de générer rapidement et facilement des contenus crédibles, qui constitueront sans aucun doute de nouveaux défis pour les groupes de défense des droits humains qui recueillent des preuves pour documenter les abus et faire en sorte que les injustices soient reconnues. Les travaux mené par le Laboratoire d’enquêtes numériques (Digital Investigations Lab) de Human Rights Watch, capable de vérifier faits et contenus, seront de plus en plus décisifs dans un avenir où l’IA générative prendra de l’importance, car des informations fausses ou trompeuses, notamment des photos et des vidéos très crédibles générées par l’IA, circulent déjà en ligne.