Il existe de nombreux éléments accréditant l’hypothèse selon laquelle le jugement humain peut être faussé par les émotions, les préjugés, voire l’hypoglycémie, avec des conséquences désastreuses pour le respect des droits humains.

Depuis des siècles, le droit en a tenu compte, en intégrant des normes relatives au comportement d’un homme (ou d’une femme) « raisonnable » ou en tenant compte de capacités réduites, dans certains cas. La recherche sur les préjugés cognitifs est en plein essor.

Pour cette raison, nombreux sont ceux qui encouragent notre confiance croissante dans les mégadonnées et les algorithmes pour faciliter, voire remplacer, le processus décisionnel humain prédictif. Les outils d’apprentissage automatique peuvent dégager des formes et des tendances dans des données volumineuses que l’esprit humain ne peut traiter. Des voitures autonomes plus sûres, des diagnostics médicaux plus précis ou encore une meilleure stratégie militaire en résulteront, susceptible de sauver de nombreuses vies.

Mais la montée en puissance des outils informatiques pourrait avoir un coût dans les années à venir, en nous faisant perdre confiance dans notre propre capacité à discerner la vérité et à établir les responsabilités pour de mauvaises décisions. Et sans pouvoir tenir les auteurs de violations pour responsables de leurs actes, il est quasiment impossible de défendre les droits humains.

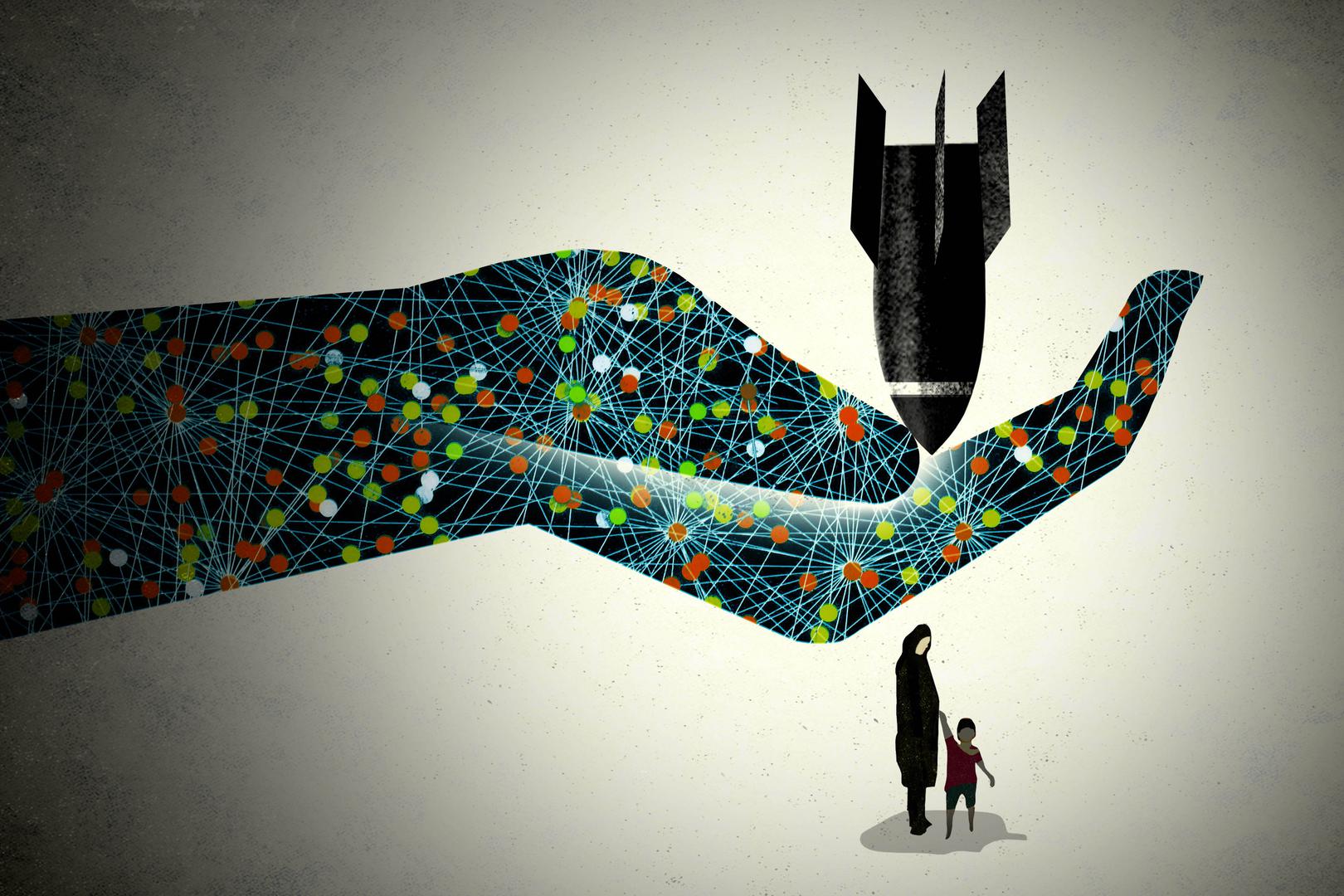

Il existe déjà une opposition largement répandue au développement d’armes entièrement autonomes. Ces armes sélectionneraient et tireraient sur des cibles en l’absence d’un contrôle humain significatif. Même ceux qui sont convaincus qu’un jour ces « robots tueurs » pourraient limiter davantage les pertes civiles que les humains – en soi une proposition très controversée – pourraient faire machine arrière à l’idée de laisser la décision finale à des algorithmes qui n’ont pas à rendre de comptes. Tentez d’expliquer aux victimes d’un massacre perpétré par apprentissage automatique qu’il s’agissait d’un problème de conception du produit et non d’un crime de guerre.

Un autre problème est celui du réflexe politique consistant à attendre des experts en technologie des réseaux sociaux qu’ils « règlent » des problèmes tels que la dissémination d’informations mensongères ou les discours de haine. Les compagnies s’intéressent au nombre de clics et aux profits générés par les internautes, non à l’équilibre subtil entre promouvoir la liberté d’expression dans des sociétés démocratiques et protéger les droits de tiers. Elles se serviront d’algorithmes, et non de juristes bien formés, pour déterminer nos droits, et même si elles pouvaient expliquer comment leurs outils prennent des décisions, ces compagnies seraient réticentes à révéler au grand jour leurs secrets de fabrication.

La transparence peut atténuer certains préjugés: si nous pouvions tester l’algorithme ou auditer les données sur lesquels il s’appuie, des corrections pourraient être envisageables. Les données s’accompagnent des préjugés, de la pauvreté et de l’injustice qui font partie intégrante de notre monde. Des données faussées ou incomplètes peuvent renforcer la prise de décision discriminatoire, comme en témoignent les outils censés prédire des crimes, la récidive ou la solvabilité financière.

Toutefois la transparence, même si elle est possible, ne peut résoudre tous les problèmes. Les décisions présidant à la détermination d’une peine de prison d’un algorithme au point peuvent être plus « rationnelles » que celles d’un juge ambitieux, remonté ou partial. Pourtant, il est contraire à la dignité humaine de décharger un juge de sa responsabilité de priver autrui de sa liberté pendant des années. Le fait d’accorder une véritable audience à un accusé et de faire preuve de compassion, d’empathie et de partager une expérience humaine est aussi essentiel que de calculer la chance de jugement juste et de défense de la dignité humaine. Parfois, les solutions à l’erreur humaine exigent d’améliorer le jugement et la responsabilité humaine, et non d’encourager son abdication ou son affaiblissement.

Les outils d’apprentissage automatique, comme toute technologie, sont un moyen et non une fin. Lorsqu’ils sont utilisés à bon escient, ils peuvent faire progresser l’établissement des responsabilités et le respect des droits. Nous devrions insister quant au fait que ces outils doivent toujours être placés sous contrôle humain et utilisés uniquement dans les cas où ils renforceraient les droits humains, les recours en cas de violations et la responsabilité humaine. C’est un choix politique que nos futurs « maîtres robots » ne pourront faire.

-------------------

Tweet

Les #algorithmes peuvent-ils aider à éviter les erreurs humaines ? Essai de @DinahPoKempner @hrw dans le Rapport mondial 2019 de HRW https://t.co/lJcTymCMow #Rights2019 pic.twitter.com/9OxRSwEqDA

— HRW en français (@hrw_fr) 17 janvier 2019